Reconocimiento facial, el sesgo es un problema en crecimiento

Tecnológicas evitan detalles sobre el problema del sesgo en reconocimiento facial

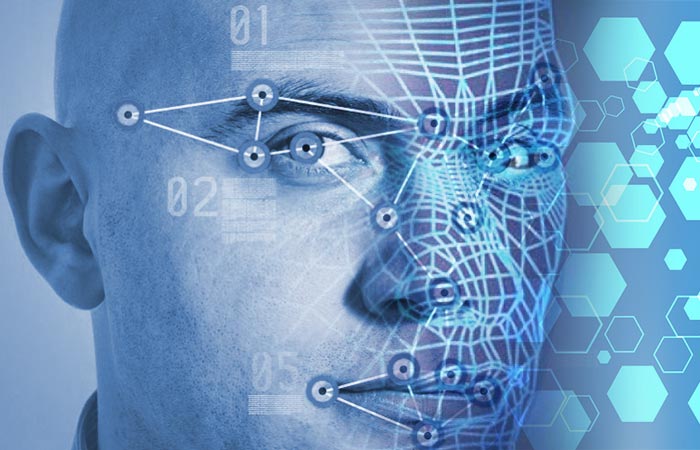

La tecnología del reconocimiento facial se posiciona en la sociedad. Ya está presente en los smartphones, computadoras, redes sociales e incluso en la autentificación de pagos en algún banco. En China, se puede comprar comida y en un baño público solicitar papel higiénico, solo con el rostro. Agencias de todo el mundo experimentan esta tecnología para vigilancia masiva; sin embargo, la inteligencia artificial en el reconocimiento facial subyace un problema estructural destacado, el problema del sesgo.

Una investigación publicada por el MIT Media Lab, en febrero de 2018, ha descubierto el detonante de la problemática. El algoritmo empleado, en el reconocimiento facial de las compañías IBM,Microsoft y Face++, posee tasas de error de hasta el 35 por ciento más altas al reconocer la piel más oscura en las mujeres en relación con los hombres de piel más clara. En consecuencia, el problema del sesgo en reconocimiento facial reforzaría los prejuicios sociales, es decir, se traslada el prejuicio social de la vida diaria a la inteligencia artificial (IA).

Noticia en nada afortunada, a la vez sentenciada en la postergación o en la desidia por distintas compañías quienes no tienen el plan "b", dicho de otra forma, no desarrollaron un plan con la intención de solucionar el problema. Cierto es que las empresas abordan el sesgo desde su propio software; pero expertos en reconocimiento facial reconocen la inexistencia de puntos de referencia a partir de los cuales permitirían al público seguir las mejoras en toda la industria. Por lo tanto, cuando una compañía sostiene el logro de reducir el sesgo en su algoritmo, es imposible interpretar y comprender el alcance significativo de ello.

Carla Grave, asociada del Centro de privacidad y tecnología de Georgetown Law, expresó a medios informativos la necesidad de introducir puntos de referencia vectoriales para el sesgo y la precisión, éstas son una serie de pruebas que determinan el desempeño de los algoritmos en diferentes grupos demográficos, entre ellos: edad, sexo y tonos de piel, segúnGrave, es imperativo y beneficioso en particular si esas empresas son contratadas por el gobierno o agencias estatales.

¿Qué acciones realizan las empresas?

De acuerdo a una encuesta informal, contactada una docena de compañías comercializadoras de sus algoritmos de IA en reconocimiento facial, identificación y análisis, todas ellas expresaron el conocimiento de la problemática del sesgo, y la mayoría aseguró la realización de acciones con la intención de reducir sus propios sistemas de software; pero, ninguna compartiría resultados obtenidos ni daría a conocer sus propios métricas alcanzadas. De ello surge la primera interrogante, si un usuario emplea con regularidad el algoritmo de reconocimiento facial ¿no tendría curiosidad o necesidad de conocer si el desempeño consistente según su género y/o tono piel es regular o peor dentro de su grupo demográfico, e incluso comparativamente con otros grupos?

Google vende algoritmos que solo detectan la presencia de rostros, no identidades; un vocero de la empresa dijo, "Evaluamos el sesgo y estamos constantemente probando nuestros modelos subyacentes en un esfuerzo por hacerlos menos parciales y más justos. No tenemos más detalles para compartir sobre esto".

Microsoft anunció mejoras hace poco en su blog, el cual incluye su software de reconocimiento de género, reduciendo el índice de error del 1.9 por ciento en las mujeres de piel más oscura. La empresa no emitió comunicado oficial, pero mencionó una publicación en su blog, de su presidente Brad Smith, que refiere a la necesidad de regulación pública y responsabilidad corporativa, en cuanto al reconocimiento facial plantea problemas fundamentales en derechos humanos como privacidad y libertad de expresión. En otras palabras, urge el establecimiento de estándares mínimos de precisión por parte del gobierno de Estados Unidos.

IBM destacó mejoras y lanzamiento de un conjunto de datos en el entrenamiento de sistemas de reconocimiento facial, para reducir el sesgo. Ruchir Puri, arquitecto jefe de IBM Watson, expresó el interés de la empresa en ayudar sobre los puntos de referencia de precisión, e indicó la necesidad de existencia de matrices de juzgamiento a los sistemas, iniciativa que debería surgir de la comunidad y no de unos pocos individuos.

Amazon no quiso responder a los interrogantes pero remitió a las fuertes críticas de la ACLU (American Civil Liberties Union/Unión Americana de Libertades Civiles) realizadas el 22 de mayo del presente año. La empresa vende su producto "Rekognition" a tres estados, que puede utilizarse con facilidad violando las libertades y derechos civiles, al identificar, rastrear y analizar personas en tiempo real e incluye la capacidad de reconocimiento de hasta cien personas en una imagen. ACLU probó el algoritmo en la identificación de diferentes miembros del Congreso y descubrió reconocimiento facial incorrecto de 28 congresistas con fotografías policiales de personas con antecedentes delictivos. Amazon continúa vendiendo el producto.

¿Cómo abordar el problema del sesgo?

Respuestas enunciadas por las distintas empresas solo demuestran conciencia de la problemática del sesgo, y en todas ellas no hay un solo indicio sobre un esfuerzo conjunto y coordinado en el abordaje del problema en sí. Según expertos en reconocimiento facial, la solución es conceptualmente simple y a la vez difícil de implementar: es imperativo la creación de pruebas de exactitud y sesgo para toda la industria.

Si bien existe un tipo de prueba semejante llamada FRVT (Face Recognition Vendor Test/Prueba de Proveedor de Reconocimiento Facial), administrado por el Institución Nacional de Estándares y Tecnología. Dicha prueba establece la precisión de los sistemas de reconocimiento facial en distintos escenarios; aunque es totalmente voluntaria. Los algoritmos que allí se envían solo corresponden a pequeñas compañías, y ninguna de las gigantes tecnológicas que comercializan sus productos los envía para las pruebas correspondientes.

La comunidad seguirá con atención el desarrollo del reconocimiento facial, asimismo, la resistencia a establecer acuerdos en materia de regulación y la búsqueda consensuada a la problemática del sesgo.

GoogleMicrosoftIBM

Informe dice que 78% de la GenZ considera el trabajo presencial esencial

Informe dice que 78% de la GenZ considera el trabajo presencial esencial Salud femenina: Claves para fortalecer el bienestar en cada etapa de la vida

Salud femenina: Claves para fortalecer el bienestar en cada etapa de la vida Disminución de vacunas infantiles podría provocar el resurgimiento de enfermedades

Disminución de vacunas infantiles podría provocar el resurgimiento de enfermedades Cuidar la piel fortalece el bienestar emocional, destaca Palmer’s

Cuidar la piel fortalece el bienestar emocional, destaca Palmer’s